●技術簡介:

1. 以YOLOv3-tiny模型為基礎的瞳孔追踪,偵測準確率可達80%,召回率接近83%

2. 平均瞳孔追踪誤差,訓練模式小於2像素,交叉測試模式小於5像素

3. 校準後穿戴式眼動儀在訓練和測試模式下的平均視線追踪誤差分別小於 2.9 度和 3.5 度

4. GPU 平台上執行每秒 可達20 個畫

●技術之科學突破性:

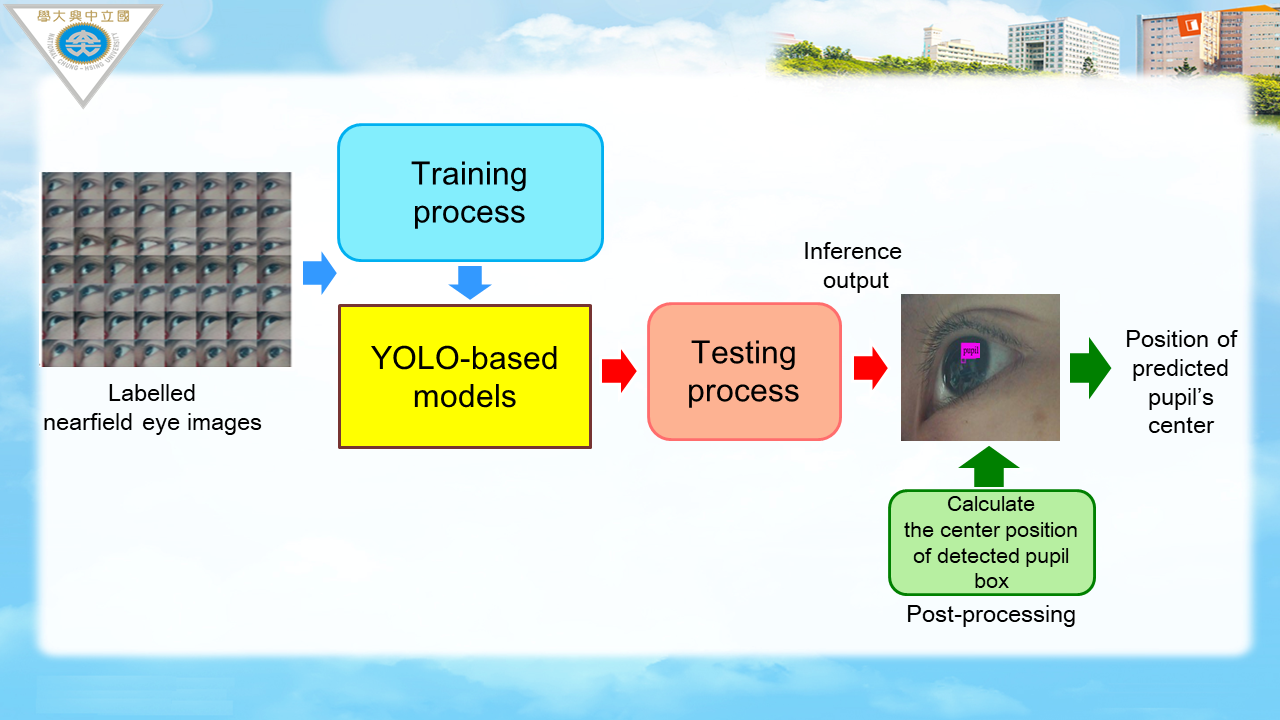

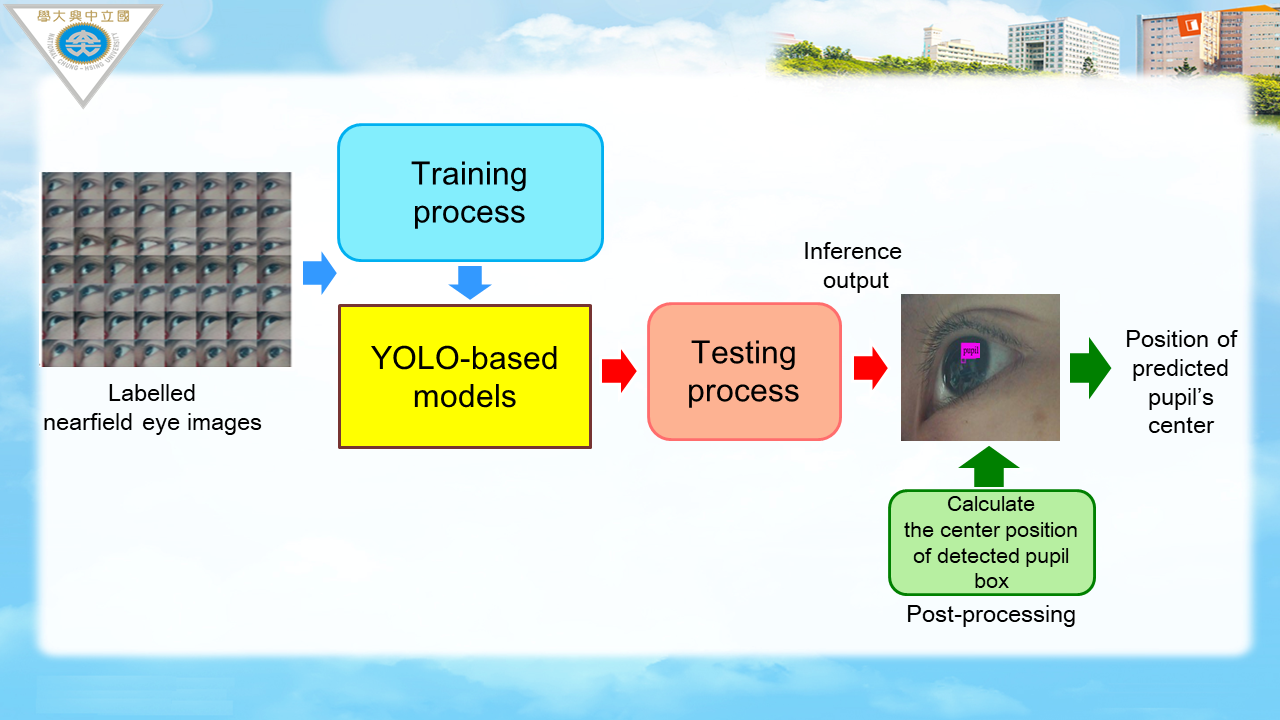

本研究的主要貢獻是通過基於 YOLOv3-tiny 的深度學習技術精確檢測近場可見光眼睛圖像中的瞳孔位置。據我們從調查相關研究中了解到,這項工作的新穎之處在於提供基於深度學習的瞳孔跟踪技術的領先參考設計,使用近場可見光眼睛圖像,用於可穿戴式凝視跟踪設備的應用。

此外,所提出的基於深度學習的瞳孔追踪技術的其他新穎性和優勢描述如下: (1) 通過使用近場可見光眼部圖像資料集進行訓練,所使用的深度學習模型實現了可見光模式下瞳孔位置的實時準確偵測。 (2) 所提出的設計在任何眼球運動條件下偵測瞳孔物體的位置,這比在近眼可見光模式下沒有深度學習技術的傳統影像處理方法更有效。 (3) 所提出的瞳孔追踪技術可以有效克服近眼可見光模式下的光影干擾,瞳孔位置偵測精度高於以往不使用深度學習技術的可穿戴式視線追踪設計。

為了提高偵測精度,我們使用基於 YOLOv3-tiny 的深度學習模型來偵測可見光近眼圖像中瞳孔的物件。我們還將其偵測結果與其他設計進行了比較,其中包括不使用深度學習技術的方法。根據精度、召回率和瞳孔追踪誤差來評估瞳孔偵測性能。通過提出的基於YOLOv3-tiny的深度學習方法,訓練後的基於YOLO的深度學習模型達到了足夠的精度,平均瞳孔追踪誤差在訓練模式小於2像素,在交叉測試模式小於5像素。

●技術之產業應用性:

穿戴式眼動儀是能夠追蹤與測量眼球位置及眼球運動資訊的一種設備,已在視覺系統、心理學、認知語言學的研究中有廣泛的應用。在教育與學習的研究上,透過眼動儀可分析出每個受測者的眼動指標,如此就能針對每位學習者,提供獨特的教學方法。

除了教育領域外,例如:市場研究與消費者調查,可應用眼動儀得知何種產品與包裝設計更能吸引消費者的目光,與行車安全方面的駕駛視線分析;此外,眼動追蹤能夠提供使用者的行為資料,對軟體設計、遊戲互動的研究都有所助益。應用眼球追蹤技術至人機互動領域,可使用眼控技術來控制電腦與手機等新穎模式的人機互動應用。

線上展網址:

https://tievirtual.twtm.com.tw/iframe/bd77728d-dc93-4ef2-8b2e-2c348882d6cc?group=23bfb1fa-dd5b-4836-81a1-4a1809b1bae5&lang=tw

國立中興大學(National Chung Hsing University, NCHU)成立於1919年,位於台中市,是台灣一所綜合性大學,提供農業、工程、科學、人文等多領域的優質教育與研究,致力於創新與國際化發展。

技術成熟度:實驗室階段

展示目的:商機推廣、研發成果展示

流通方式:自行洽談

*服務單位

*姓名

*電話

*您參觀這項展品的主要目的?

*您是否希望進一步洽談

*您的職務類別

*展覽整體評價

*最喜歡的展區

*期待展覽著重的技術領域

*是否願意收到電子報/最新資訊

其他建議

敬請期待!