●技術簡介:

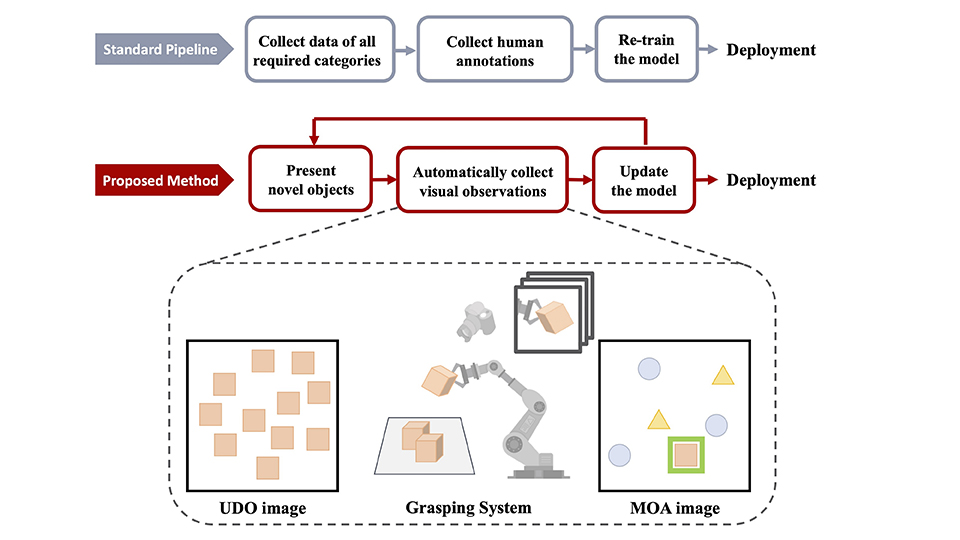

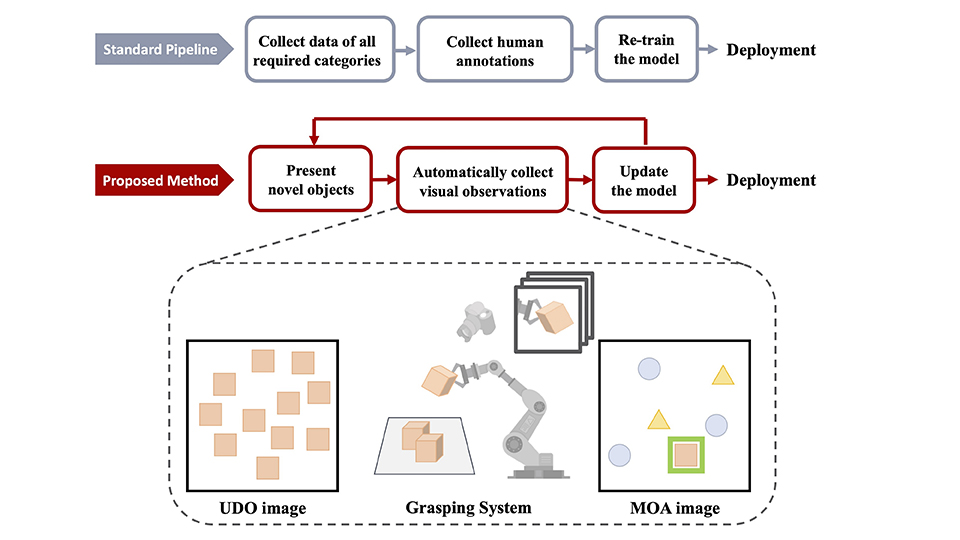

未來的自動化工業場域中,物件偵測模型必須克服標註樣本過少的問題及能夠迅速針對當下產線需求進行微調。本技術開發全新物件偵測學習技術,使少樣本物件偵測模型與機械手臂進行協作,對新目標物進行動態多樣性資料收集與逐步適應於當前任務,並能持續學習進步,訓練過程無需任何人為標註資料,在相關領域呈現極大進展。

●技術之科學突破性:

因應工業自動化時代的到來以及落實深度學習於工業場域的應用,本展示特別強調兩項「全新突破」技術:(1) 基於互動式感知的自動化物件偵測學習ODIP,以及(2) 全新少樣本物件偵測模型DAnA-FasterRCNN。

[基於互動式感知的自動化物件偵測學習 ODIP]

- 全新的自動化物件偵測方法,透過將少樣本物件偵測模型與機械手臂進行協作,模仿人類拿取物品並觀察學習的過程,以及全自動的方式收集資料與標註並對當前環境與目標進行適應,免除人為標註所需之成本,且能持續進步(from 52.5 mAP to 62.4 mAP)。

- 以在線(online)的方式持續更新資料庫與模型知識,無需事前預設當下及未來所需對應之目標物,能靈活地針對當前的下游任務對模型進行微調。

- 我們於ODIP中提出新的混合訓練方法,其所訓練出之模型其表現(62.4 mAP)顯著高於傳統物件偵測模型(54.0 mAP),並可被應用於物體密集之場景,且訓練過程中無需任何人為標註資料。

- 實務上,有機會將目前工廠物件辨識調教所需的時間有三星期降低到一小時內。

[少樣本物件偵測模型 DAnA-FasterRCNN]

- 傳統物件偵測模型只能對應訓練集所包含之物體種類,重新訓練則需耗費大量人力物力重新收集標註資料。此模型只需少量標註資料便能快速適應至新的應用場域。

- 全新雙向感知注意力機制Dual-Awareness Attention,使經典物件偵測模型FasterRCNN能在少樣本範式下進行訓練,並在少樣本物件偵測任務上的表現大幅超越現今其他同類型方法,較目前最好的模型相對高出47%。

- 提出的方法對於少量樣本的利用更加高效,對於品質不一的樣本圖片(support images)有更高的穩定性,在100次隨機測試下其mAP的標準差僅0.46,顯著低於其他同類模型。

本次的技術已在過去一個月內被頂尖會議論文IROS 2021以及頂尖期刊IEEE Transactions on Multimedia (TMM) 所接受。

●技術之產業應用性:

開發的技術 (ODIP) 可以讓機器手臂在生產線快速部署,人機共同協作,協助工業4.0落地。同時考慮生產線上訓練樣本數太少的問題,將少量樣本學習 (few-shot learning) 的架構帶入深度學習網路設計,解決生產線上訓練樣本太少的問題以及大大降低技術導入生產線的時間,為邁入工業自動化最關鍵的技術。

入選為科技部『AI 創新研究中心專案計畫』,並在2019年獲得科技部「AI 創新研究中心投資潛力獎第一名」。2020年五月與科技部召開記者會共同發表「打破AI黑盒子-可解釋性的人臉辨識模組」,獲得極大的關注,此外,團隊研究成果也在600多組技術團隊中脫穎而出,榮獲2020未來科技獎,並將相關技術以開源的方式供全球研究社群使用(如[2])。

本團隊的其他研究工作除了在頂尖會議、期刊發表外,更在數個國際研究競賽中獲得重要的獎項。更透過產學合作合作與國內外企業合作落實在產品當中,目前的合作對象包括NVIDIA、Microsoft Research、IBM Watson、Qualcomm、MediaTek、FIH(富智康)、HTC、廣達、達明機器人、群暉、訊連科技等。

線上展網址:

https://tievirtual.twtm.com.tw/iframe/e04c7e58-8476-4060-8c05-9e9b60e42eea?group=23bfb1fa-dd5b-4836-81a1-4a1809b1bae5&lang=tw

技術成熟度:實驗室階段

展示目的:商機推廣、研發成果展示

流通方式:自行洽談

*服務單位

*姓名

*電話

*您參觀這項展品的主要目的?

*您是否希望進一步洽談

*您的職務類別

*展覽整體評價

*最喜歡的展區

*期待展覽著重的技術領域

*是否願意收到電子報/最新資訊

其他建議

敬請期待!